基于自监督的内窥镜单目深度估计算法

内窥镜检查在多种疾病的早期检测和治疗中发挥着举足轻重的作用,人工智能(AI)辅助技术在疾病筛查中越来越受到重视。其中,内窥镜序列的深度估计对于一系列人工智能辅助手术至关重要。然而,由于数据集中独特的环境复杂性和限制,内窥镜深度估计算法的开发提出了巨大的挑战。

课题组提出了一种多尺度特征融合自监督深度估计卷积神经网络,探索内镜图像亮度变化对深度估计精度的影响,相关成果以“Self-Supervised Monocular Depth Estimation for Endoscopic Imaging”为题,发表在高水平学术期刊《IEEE Journal of Biomedical and Health Informatics》。

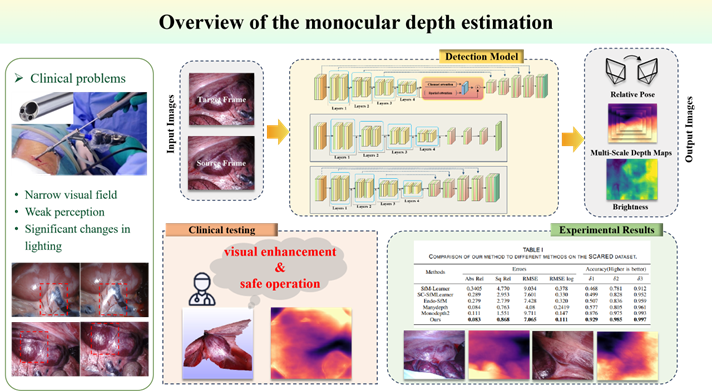

本文提出了一种自监督深度估计网络,以全面探索内窥镜图像中的亮度变化,并融合不同尺度的特征信息,以实现对内窥镜深度的准确预测。首先,设计了FlowNet模块,通过计算多尺度结构相似性来评估相邻帧的亮度变化;其次,提出了一种特征融合模块,用于捕获多尺度上下文信息;实验表明,该算法在Stereo Correspondence and Reconstruction of Endoscopic Data(SCARED数据集)中的平均准确率为97.03%。基于SCARED数据集的训练参数,该算法在其他两个数据集(EndoSLAM和KVASIR数据集)上均取得了优异的性能,表明该算法具有良好的泛化性能。

如下图所示,可以直观地看出,亮度波动违反了亮度一致性假设,往往对传统方法的内镜场景提出挑战。然而,该方法在定性和定量比较中均表现出良好的性能。

从泛化实验中可以看出,该方法在预测边缘信息和细节方面表现出了优越的性能,与实际深度更吻合。值得注意的是,在靠近结肠壁和深边缘和褶皱内,这种方法有效地表达了细节特征,从而产生了整体更好的效果。