联合器械分割的单目内窥镜图像深度估计方法

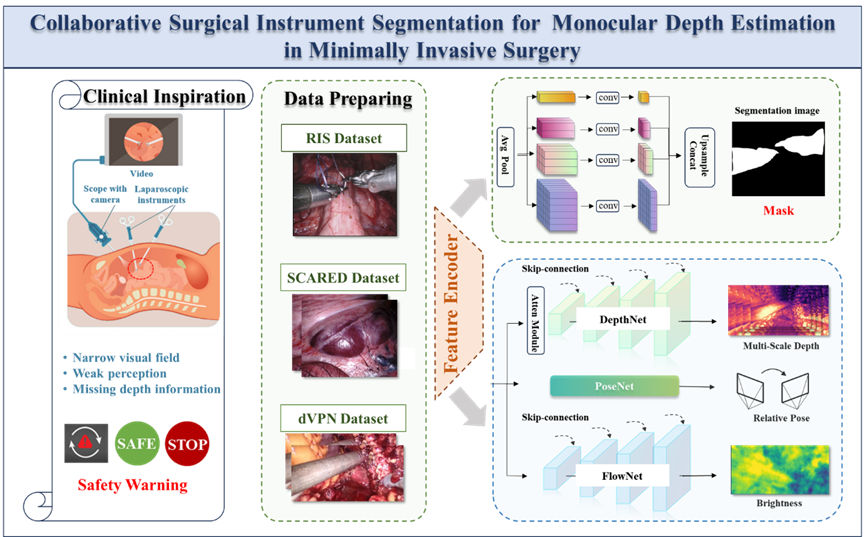

在微创外科手术中,深度估计对图像引导的手术操作至关重要,因为它能提供三维空间感知。然而,受限于手术场景中的遮挡、高光反射等复杂情况,单目图像的深度估计仍然十分困难。因此,如何在复杂手术场景下实现更准确的深度感知成为一个亟待解决的问题。本文提出了一种两阶段的自监督单目深度估计框架,其核心是引入手术器械分割任务来辅助深度估计。相关成果于2025年8月以“Collaborative Surgical Instrument Segmentation for Monocular Depth Estimation in Minimally Invasive Surgery”为题,被期刊《Medical Image Analysis》接收。

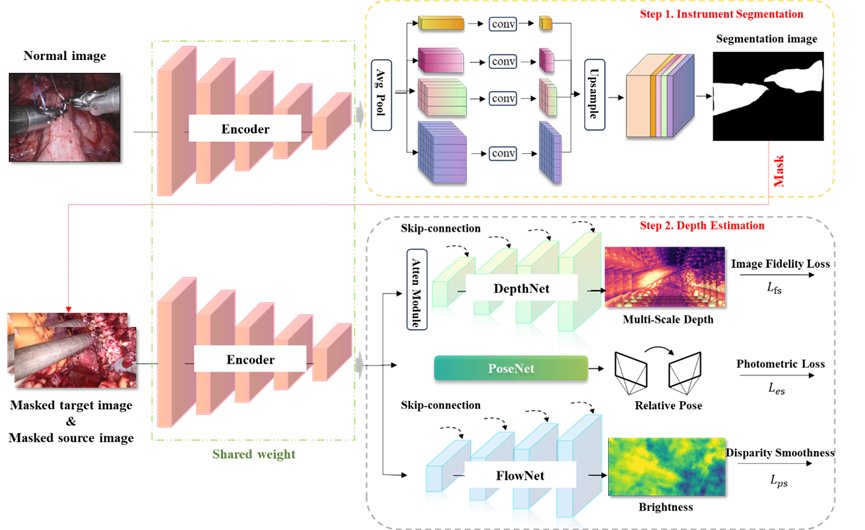

本文提出了一种结合手术器械分割与单目深度估计的协同学习框架。该方法的核心思想在于利用器械分割所提供的语义与空间约束来辅助深度估计。具体而言,该框架采用两阶段训练机制:在第一阶段,分别在 RIS、SCARED 等内镜数据集上独立训练器械分割与深度估计模型,以获取任务特定的特征表示;在第二阶段,将 dVPN 数据集上预测得到的分割掩码与原始 RGB 图像融合,从而引导深度预测的细化与优化。与此同时,框架采用共享编码器与多解码器结构,实现跨任务的特征共享与协同优化,算法模型如下图所示。

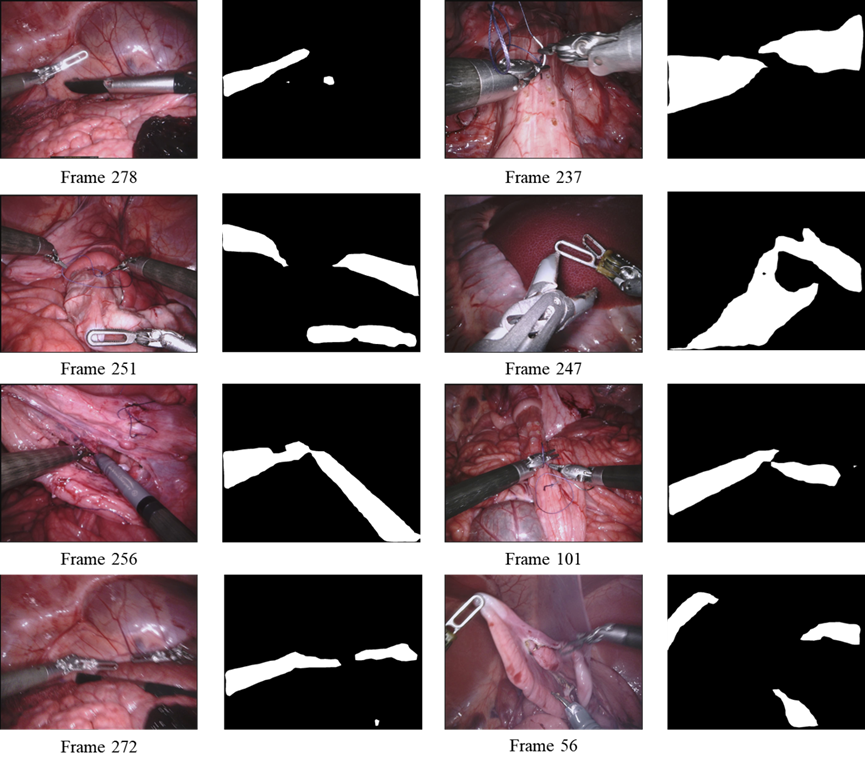

下图展示了第一阶段的器械分割算法可视化结果,前三行的图像帧与MICCAI2017器械分割挑战赛官方可视化检测图像中使用的帧保持一致,实验结果表明该算法能有效识别不同的手术器械。

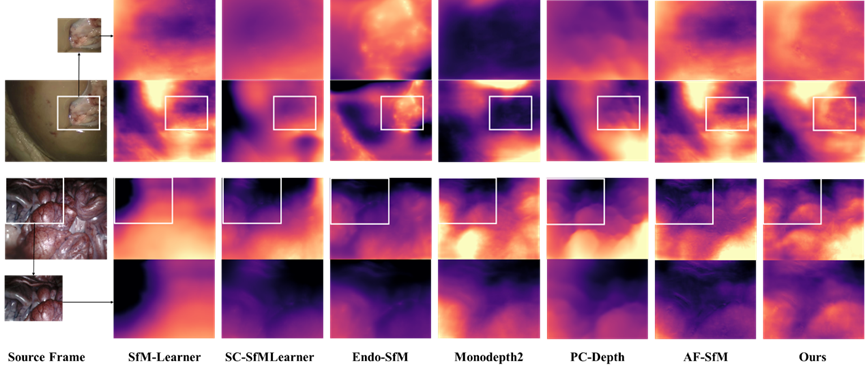

第一阶段深度估计算法可视化结果如下图,在 SCARED 数据集上,传统的自监督方法在低纹理区域容易出现模糊或不连续的深度预测,Monodepth2 和 PC-Depth 在光照良好的场景表现尚可,但在暗区效果较差。相比之下,本文方法能够更好地保持组织细节和结构感知。在SERV-CT 数据集进行泛化实验,实验结果表明受遮挡、高光和弱纹理影响,多数方法的预测质量明显下降,常出现噪声和不连续现象。本文方法在这些挑战场景中依然能生成更加连贯、解剖合理的深度结果,并展现出更好的跨数据集泛化能力。

第二阶段联合器械分割的单目深度估计可视化结果如下图所示,在 DPVN 数据集上,传统方法往往出现深度过度平滑、碎片化或边界模糊的问题,难以稳定捕捉解剖结构。相比之下,本文方法能够生成更连贯、逼真的深度图,既能保留清晰的解剖边界和结构梯度,也能在受器械、血迹或光照影响的复杂区域保持稳定预测。

未来工作将进一步扩展该框架的功能,例如辅助外科医生在手术过程中判断器械与组织的安全距离,并将器械分割由二分类拓展至更细粒度的多类别分类,以实现更高水平的智能化与安全保障。这一研究为机器人辅助手术中的三维感知与安全性提升提供了新的思路和方向。